Informatik Das ist Haydn. Ganz sicher!

Auch wenn sie ein bestimmtes Stück noch nie gehört haben, erkennen viele Musikliebhaber sofort den Komponisten. Diese intuitiven Fähigkeiten hat ein Computer noch nicht. Immerhin: Bei der Unterscheidung musikalischer Epochen ist er schon recht gut

Ute Weber hört leidenschaftlich gerne klassische Musik. Sie liebt vor allem Orchesterwerke. Kürzlich besuchte sie jedoch einen Klavierabend. Als der Pianist am Ende die Zugabe anstimmte, wusste Ute Weber zunächst nicht, von wem das Stück stammte. Sie hatte es noch nie gehört, war aber schon nach wenigen Takten überzeugt, dass es von Joseph Haydn sein musste. „Das könnte doch auch von Mozart gewesen sein“, sagte ihr Mann später. Aber Ute Weber war sich sicher – auch wenn sie nicht sagen konnte, woran sie den Komponisten erkannt hatte. Mit ihrer Fähigkeit, die musikalische Stilistik zu erfassen und zuzuordnen, ist Frau Weber nicht allein. Viele musikalische Laien entwickeln über Jahre hinweg ein Ohr für solche Feinheiten. Dabei können sie meist keine rationalen Gründe angeben. Denn sie erkennen den Komponisten eines unbekannten Stückes intuitiv, und nicht durch systematisches Analysieren des Notentextes.

Wir wollten wissen, ob sich diese intuitiven Fähigkeiten auch einem Computer beibringen lassen. Er sollte also lernen, Aufnahmen verschiedener Musikstile zu unterscheiden. Dabei fingen wir mit einer vergleichsweise leichten Aufgabe an – der Unterscheidung der vier Epochen Barock, Klassik, Romantik und Moderne.

Eine Herausforderung ist dabei, dass sich auch Stücke einer Epoche stark voneinander unterscheiden. Sie haben ganz unterschiedliche Melodien, Taktarten, Tempi und Tonarten. Trotz dieser Unterschiede gibt es stilistische Gemeinsamkeiten, die sich nur schwer in Worte fassen lassen. Der Computer muss also in der Lage sein, generelle Prinzipien des Musikstils zu erfassen – und diese Prinzipien auf neue Stücke zu übertragen. So wie Ute Weber. Eine solche „Transferleistung“ betrifft beispielsweise die Besetzung des Stückes. Frau Weber mag vor allem die Orchesterwerke Haydns. Sie erkannte dessen musikalische Handschrift aber auch in jenem Klavierstück. Für einen Computer ist diese Transferleistung schwierig, weil der Klang eines Orchesters sich deutlich von dem eines Flügels unterscheidet.

Damit unser Algorithmus diese Flexibilität erlernt, beruht unser Ansatz auf den harmonischen Eigenschaften der Musikstücke, die von den Tonhöhen und Akkorden sowie deren Beziehungen untereinander bestimmt sind. Um Musikaufnahmen hinsichtlich dieser Eigenschaften zu vermessen, sind Techniken der digitalen Signalverarbeitung nötig.

Dabei teilt der Algorithmus die Aufnahme zunächst in zeitliche Abschnitte von etwa einer Zehntelsekunde Dauer und misst dafür jeweils die dominanten Frequenzen. Dieses Vorgehen heißt auch Spektralanalyse und ähnelt der Zerlegung des weißen Lichts in seine Spektralfarben. Die gemessenen Frequenzen werden dann musikalischen Tonhöhen zugeordnet. Zum Beispiel hat der Kammerton a, auf den Orchestermusiker ihre Instrumente stimmen, eine Grundfrequenz von etwa 440 Hertz (Schwingungen pro Sekunde).

Damit die Spektralanalyse unabhängiger von der instrumentellen Besetzung ist, werden im nächsten Schritt alle Tonhöhen mit dem Namen c – unabhängig von ihrer Lage (Oktave) – zusammengefasst. Dasselbe geschieht mit den Tonhöhen cis oder des, allen mit Namen d und so fort. Insgesamt gibt es zwölf dieser „Tonhöhenklassen“, deren jeweilige Energie der Algorithmus für jeden Abschnitt errechnet.

Auf dieser Grundlage werden nun harmonische Eigenschaften gemessen. Anhand der Verteilung der Energie auf die zwölf Tonhöhenklassen lässt sich beispielsweise die Komplexität der Harmonik abschätzen. Die Komponisten der Klassik, wie etwa Haydn, konzentrierten sich meist auf wenige Tonhöhenklassen, die zur Tonart des Stückes passen. Ihre Musik ist somit weniger komplex als die des 20. Jahrhunderts (Moderne). So sind die Tonhöhenklassen in der so genannten Zwölftonmusik alle ungefähr gleich präsent. Analysiert man den Verlauf der harmonischen Komplexität über die letzten 300 Jahre Musikgeschichte, zeigt sich um das Jahr 1900 ein sprunghafter Anstieg, der mit dem Aufkommen solcher modernen Stile erklärt werden kann.

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenMessbar sind auch die Häufigkeiten bestimmter Zusammenklänge. Hier kommt eine weitere Transferleistung ins Spiel: Für Ute Weber spielt es nämlich keine Rolle, in welcher Tonart das Haydn-Stück steht, um die Handschrift des Komponisten zu erkennen. Wichtig sind lediglich die Beziehungen zwischen den Tonhöhen. Damit auch unser Algorithmus den Musikstil unabhängig von der Tonart erkennen kann, erfassen wir nur die Abstände zwischen den Tonhöhen.

Alles in allem analysieren wir auf diese Weise über hundert verschiedene Merkmale einer Musikaufnahme. Von diesen Merkmalen auf den Musikstil zu schließen, ist eine überaus komplexe Aufgabe. Um diese zu bewältigen, braucht der Computer Erfahrung. Er muss – wie Ute Weber – hören, hören, hören. Wir fütterten ihn daher zunächst mit mehr als tausend „Trainingsbeispielen“, die ihm halfen, bestimmte harmonische Eigenschaften mit dem jeweiligen Musikstil zu verknüpfen. Für das Training berücksichtigten wir Klavier- und Orchesterstücke von verschiedenen Komponisten in unterschiedlichen Tonarten, Tempi und Taktarten, damit der Algorithmus am Ende die gewünschten Transferleistungen erbringen kann.

Wie gut funktioniert nun unser Algorithmus? Das testeten wir an etwa 500 neuen Stücken. Das Ergebnis: Etwa drei Viertel dieser Stücke wurden der richtigen Epoche zugeordnet.

Allerdings sind solche Ergebnisse mitunter mit Vorsicht zu genießen. Ist beispielsweise auf einer Trainings-CD mit Barockmusik das typische Hintergrundrauschen einer alten, unbearbeiteten Originalaufnahme zu hören, kann der Algorithmus dieses Rauschen als Merkmal dieser Epoche verstehen. Der Algorithmus erkennt die Barockstücke von dieser CD womöglich am Rauschen, hat also keine generellen Eigenschaften des Musikstils gelernt. Barockstücke ohne Rauschen ordnet dieser Algorithmus dann falsch zu.

Solche Probleme treten besonders bei bestehenden Technologien auf, die für die Unterscheidung von Pop-, Rock- und Jazz-Aufnahmen verwendet werden. Diese Algorithmen erfassen vor allem die Klangfarbe, auf die sich das Rauschen stark auswirken kann. Unser Algorithmus lässt sich jedoch kaum davon verwirren. Sogar eine besonders schwierige Transferleistung klappt damit einigermaßen gut: Trainiert man den Algorithmus nur auf Klaviermusik kann er auch Orchesterstücke noch gut einordnen. Die harmonischen Merkmale bilden also eine gute Grundlage für die Stilerkennung.

An der Erkennung einzelner Komponisten muss jedoch noch gearbeitet werden. Bei einer Unterscheidung von insgesamt elf Komponisten erreichten wir in ersten Tests eine Trefferquote von etwa 40 Prozent. Es wird also noch eine Weile dauern, bis der Algorithmus Ute Weber schlagen kann. Doch auch die gröbere Zuordnung zu musikalischen Epochen kann überaus nützlich sein. Denn wenn Frau Weber sich im Internet Musik von Joseph Haydn herunterlädt, stöbert sie gerne in der Liste mit Aufnahmen, die andere Haydn-Liebhaber ebenfalls kauften. Natürlich findet sie hier nur die populären, von vielen Leuten gehörten Werke. Würde diese Liste von einem Algorithmus wie dem unseren erstellt, erhielte sie auch Stücke von Komponisten, die weithin unbekannt sind. Ute Weber könnte viel Neues entdecken.

Verplappert

Unser Gehirn beeindruckt mit seiner Fähigkeit, akustische Signale zu verarbeiten. Auch das können Computer lernen – zur Freude der Polizei

Ein Spaziergang durch die Stadt. In den Cafés entspanntes Geplauder. Auf der Baustelle ruft der eine dem anderen etwas zu, wegen des Lärms kaum zu verstehen. Eine Straßenbahn quietscht um die Ecke, an der Kreuzung hupt jemand genervt. In der Hecke schnattert eine Spatzenfamilie. Fast nirgends ist Stille, unser Trommelfell schickt Signale ans Hirn, sobald es sich um einen Millionstel Millimeter bewegt.

Denn wenn wir etwas hören, passiert zunächst nichts anderes: Die Schallquelle setzt die Luft in Bewegung. Es kommt zu winzigen Luftdruckveränderungen, die sich fortpflanzen und auf unser Trommelfell treffen. Diese 1-Cent-Stück-große Membran ist über ein filigranes System aus Knöchelchen und Innenohr mit unserem Gehirn verbunden. Erst dort wird aus dem Auf und Ab des Luftdrucks ein Geräusch, dass wir eindeutig zuordnen können: der Lärm eines Presslufthammers oder ein Stück von Bach. Signalverarbeitung par excellence.

Was unser Gehirn mühelos meistert, ist für Computerprogramme eine ungemein große Herausforderung. Denn zur Analyse der Luftdruckschwankungen müssen sie pro Sekunde eines Audiosignals etwa 40 000 Zahlenwerte verarbeiten. Diese gilt es mit den Werkzeugen der digitalen Signalverarbeitung so zu bearbeiten, dass sie möglichst präzise Informationen liefern.

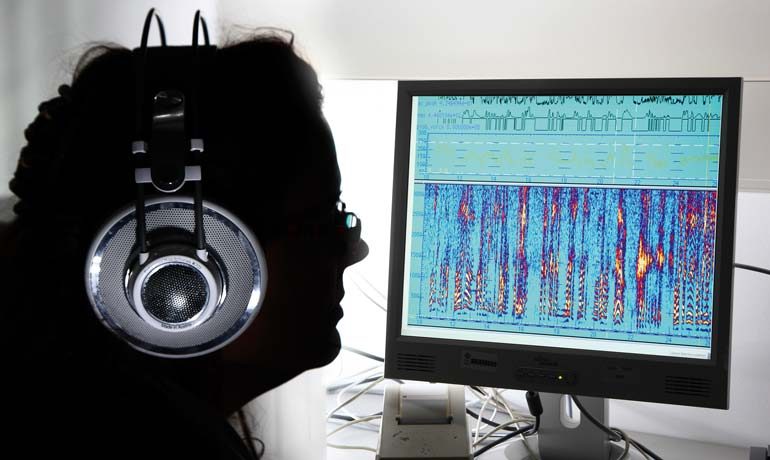

Eindrucksvolle Erfolge erzielen dabei beispielsweise die Spezialisten der Kriminalpolizei. Wenn es um die Identifizierung eines Erpressers geht, können die forensischen Phonetiker nicht nur einzelne Laute einer Bandaufnahme mit der Stimme des Verdächtigen abgleichen. Die Algorithmen sind auch in der Lage, typische Betonungen, das Timbre einer Stimme, den Dialekt oder die Sprechmelodie zu unterscheiden – unter Umständen besser als wir Menschen. Dafür reicht meist eine Vergleichsaufnahme von gerade einmal 30 Sekunden.

von Joachim Schüring